2 杭州脉流科技有限公司 310051;

3 空军军医大学西京医院心血管内科,西安 710032;

4 浙江省温州市人民医院心血管内科 325099;

5 浙江省金华市中心医院心血管内科 321000

心血管疾病严重威胁着人类的健康,具有高患病率、高致残率和高病死率的特点[1]。其早期的诊断与治疗有助于改善心脏的功能和患者的预后,降低患者的病死率。左心室(left ventricle,LV)的准确分割是量化心室容积、射血分数、左心室质量、壁增厚以及壁运动异常等临床指标以定量分析心脏整体和局部的功能,进而诊断和治疗心血管疾病的关键步骤[2]。心脏CT血管造影术(cardiac CT angiography,CCTA)由于无创、操作简便,已经成为临床上一种重要的诊断方法[3]。然而,由于心脏CT图像中左心室区域与背景区域对比不明显、存在噪声等影响,使得左心室分割存在一定的难度。左心室的手动分割既费时又费力,其准确的分割依赖于有经验的操作者,否则易受操作者主观性影响,增加误诊率。计算机辅助诊断(computer aided diagnosis,CAD)系统可提供一种更准确、更客观的自动高效的辅助诊断方式,其中,左心室的分割是设计用于诊断心血管疾病的医学CT图像CAD系统的重要步骤。因此,左心室的分割方法研究具有重要的科学意义和应用价值。

Vikram等[4]提出一个从粗到细的框架进行CT左心室的分割,首先定位左心室,然后利用具有形状约束的主动轮廓演化技术进行细化。Medina等[5]提出一种基于水平集变形轮廓的分割技术用于CT左心室的分割,首先分割左心室内膜,然后左心室外膜基于该内膜的分割形状作为其初始曲线进行演化分割。近年来,随着人工智能和深度学习的发展,基于神经网络的分割方法已成为非常热门的研究课题。该方法可自动提取高层次的抽象特征,无需研究者根据专业知识及长期经验选取或构建可能有用的特征。2017年,Zreik等[6]首次利用卷积神经网络(convolutional neural networks,CNNs)对CT左心室进行分割。

U-Net模型[7]是一种适用于医学图像分割的卷积神经网络模型,对训练数据量要求不是很高。本研究提出一种基于U-Net的深度学习方法分割CT左心室。该方法在原始4层U-Net基础上,加深层数至8层,以提炼出更深层次的抽象信息,并且引入辅助路径作深监督[8],使得深层特征图也能求得损失,提高模型分割精度。

1 资料方法 1.1 分割网络结构如图 1所示,该8层U-Net模型由收缩路径(左:编码器)和扩张路径(右:解码器)组成。其中,收缩路径用于编码处理输入图像,获取上下文信息;扩张路径用于解码修复图像细节和空间维度,产生像素级的标签输出,实现精确的定位。

|

| 图 1 8层U-Net网络结构 |

|

|

其收缩路径包括9个编码块,每个编码块包含两个3×3卷积层(步长为1,零填充数为1),每个卷积层后添加有一个批量归一化层(batch normalization,BN层,加速网络收敛)和一个Leaky ReLU激活层(负轴斜率为0.1,使得负轴信息不会全部丢失,一定程度上防止Dead ReLU问题),每个编码块利用一个2×2最大池化层(步长为2,无零填充)进行下采样,将特征图大小减半,到下一个编码块的第一个3×3卷积层,将特征通道数加倍。

其扩张路径包括8个解码块,每个解码块包含两个3×3卷积层,每个卷积层后同样添加有一个BN层和一个LeakyReLU激活层,每个解码块利用一个4×4反卷积层(步长为2,零填充数为1,增大感受野以提高上采样的程度),将特征图大小加倍,随后添加一个ReLU激活层(增强深度神经网络模型的非线性能力)进行上采样,到下一个解码块的第一个3×3卷积层,将特征通道数减半。

在其定位操作中,采取叠操作形式的跳跃连接(图 1中的skip connection:concatenation),将收缩路径中每个编码块输出的浅层特征图与扩张路径中对应解码块输入的深层特征图(通过上采样操作获得)按照通道维度进行连接,随后连续的卷积层基于该信息学习,缓解随网络层数增加而导致的梯度弥散问题。在最后一个解码块中,利用一个1×1卷积层(步长为1,无零填充)将特征向量映射到一维空间。在收缩路径中,9个编码块的特征通道数依次为8、16、32、64、128、256、512、1 024、2 048,整个编码器部分共包含18个卷积层。在扩张路径中,前7次上采样操作添加有辅助路径(图 1中的aux1~aux7)。通过辅助路径作深监督,使得深层特征图也能求得损失,提高分割精度及加快深度神经网络的收敛速度。其将当前特征图经过多次上采样操作及一个1×1卷积层恢复到与原始图像一样大小,并将特征向量映射到一维空间,从深到浅分别以0.02、0.04、0.06、0.08、0.1、0.2、0.5、1对经这7条辅助路径输出的损失值及最后一个解码块输出的损失值进行加权求和,整个解码器部分共包含60个卷积层。

1.2 数据采集及处理本文收集66例患者在CCTA扫描下的左心室DICOM图像数据,图像大小为512×512像素,每个病例间隔取14幅,前后包括左心室未出现及消失后的图片各2幅,共924幅。对该数据统一调整窗宽600 HU、窗位100 HU,然后转换为灰度范围为0~255的JPG图像数据。鉴于人工标注图像数据的费时费力,以及带来的诸多不确定因素,本文使用Graph Cut [9]对其进行标注,使得标注数据更加稳定可靠。最后划分60个病例作为训练集(840幅),6个病例作为测试集(84幅)。

1.3 数据在线扩增对840幅训练集进行10倍数据在线扩增。不同的迭代批次可获得不同的训练集,以提高模型的泛化能力及鲁棒性。其在线扩增方式具体为,对每幅图像进行随机旋转、平移、剪切、缩放及翻转变换,对该不同变换的组合循环变换10次,使得训练集扩增10倍至9240幅。其中,图像随机旋转的角度范围为-5°~5°;在水平方向随机平移的像素范围为(-0.05×图像宽度)~(0.05×图像高度),在竖直方向随机平移的像素范围为(-0.05×图像高度)~(0.05×图像高度);随机剪切的角度范围为-5°~5°;随机缩放的比例范围为0.95~1.05,小于1的进行放大,大于1的进行缩小;随机翻转随机取值-1、0、1,若为-1则进行水平翻转,若为0则进行垂直翻转,若为1则同时进行水平及垂直翻转。

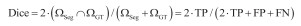

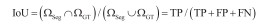

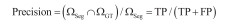

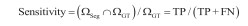

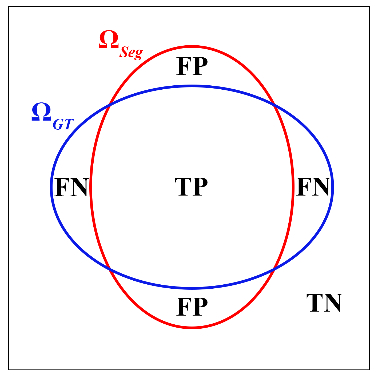

1.4 分割评估指标本文采用Dice系数、IoU系数、精确度(precision)及灵敏度(Sensitivity)四项指标评估分割结果与金标准(GT)之间的一致性。如图 2所示,ΩSeg表示分割得到的目标区域,等于TP + FP;ΩGT表示标准的目标区域,等于TP + FN。其中,TP表示正确分割为正类的像素数,TN表示正确分割为负类的像素数,FP表示错误分割为正类的像素数,FN表示错误分割为负类的像素数。Dice系数[式(1)]和Iou系数[式(2)]度量了分割得到的目标区域与标准的目标区域的空间重合度,精确度(precision)[式(3)]度量了分割得到的目标区域中实际为正类像素的比例,灵敏度(sensitivity)[式(4)]度量了标准的目标区域中被正确分割的比例。四项指标评估值都在0到1之间,值越大代表ΩSeg与ΩGT之间的一致性越高,分割结果越好。

|

(1) |

|

(2) |

|

(3) |

|

(4) |

|

| 图 2 分割结果和金标准(GT)得到的两个区域ΩSeg(红色轮廓包围)和ΩGT(蓝色轮廓包围)的示意图 |

|

|

实验使用的计算硬件为NVIDIA GTX1080Ti显卡,软件包基于PyTorch。训练分割网络时,使用MSRA初始化[10]进行神经网络的权重初始化,并读取840幅训练集和84幅测试集,对其进行零均值,单位方差的归一化操作。设置学习率learning rate=2e-4,分块大小batch size=16,迭代批次epochs=100,采用二值交叉熵(BCE)损失函数估量网络的预测值与真实值的不一致程度,通过Adam优化函数[11]使反向传播(BP)算法逐层更新网络参数。

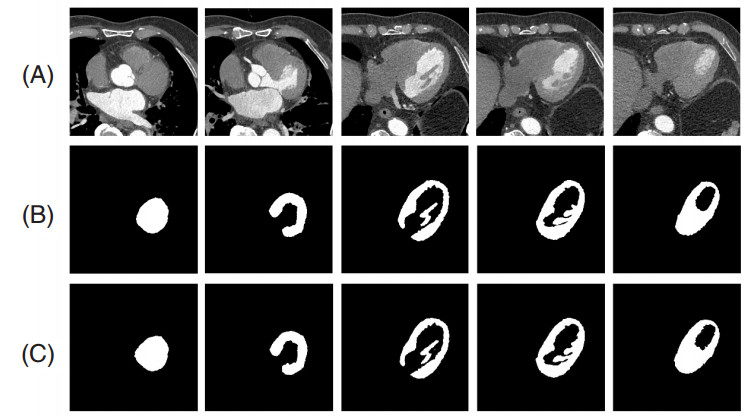

图 3展示了一例患者的5幅CT左心室图像及其相应的分割结果,表 1给出了本文方法分割CT左心室的评估结果。可以看出,本文方法对于CT左心室具有较高的分割精度。其中,Dice=95.20%、IoU=92.12%表明分割得到的左心室区域和标准的左心室区域的空间重合度较高,精确度为97.45%表明分割得到的左心室区域中标准区域占的比重较高,敏感度为94.45%表明分割左心室区域的能力较强。

|

| (A):原图;(B):金标准;(C):本文方法的分割结果 图 3 一例患者的5幅左心室图像及其相应的分割结果 |

|

|

本文方法以基于8层U-Net的卷积神经网络模型为分割模型,以提取更深层次的抽象信息,并引入深度监督机制,以进一步提高模型的分割精度。使用Graph Cut对数据集进行标注,使得标注数据更加稳定可靠。因训练数据少,采取数据在线扩增方式以提高模型的泛化能力。实验结果显示,本研究方法分割CT左心室的精度较高,表明本文方法可较为理想地实现CT左心室的分割。

| [1] | Mendis S, Puska P, Norrving B, et al. Global atlas on cardiovascular disease prevention and control[M]. Geneva: World Health Organization, 2011. |

| [2] | Tavakoli V, Amini AA. A survey of shaped-based registration and segmentation techniques for cardiac images[J]. Computer Vision & Image Understanding Cviu, 2013, 117(9): 966-989. DOI:10.1016/j.cviu.2012.11.017 |

| [3] | Tust T, Cury RC. Stress myocardial CT perfusion: an update and future perspective[J]. Jacc Cardiovascular Imaging, 2011, 4(8): 905-916. DOI:10.1016/j.jcmg.2011.04.017 |

| [4] | Vikram A, Anthony Y, Chesnal A, et al. A complete system for automatic extraction of left ventricular myocardium from CT images using shape segmentation and contour evolution[J]. IEEE Transactions on Image Processing, 2014, 23(3): 1340-1351. DOI:10.1109/TIP.2014.2300751 |

| [5] | Medina R, Bautista S, Vanegas P, et al. Left ventricle myocardium segmentation in multi-slice computerized tomography[C]//2016 IEEE ANDESCON. IEEE, 2016: 1-4. DOI: 10.1109/ANDESCON.2016.7836246. |

| [6] | Zreik M, Leiner T, De Vos B D, et al. Automatic segmentation of the left ventricle in cardiac CT angiography using convolutional neural networks[C]//2016 IEEE 13th International Symposium on Biomedical Imaging (ISBI). IEEE, 2016: 40-43. DOI: 10.1109/ISBI.2016.7493206. |

| [7] | Ronneberger O, Fischer P, Brox T. U-net: Convolutional networks for biomedical image segmentation[C]//International Conference on Medical image computing and computer-assisted intervention. Springer, Cham, 2015: 234-241.Part of the Lecture Notes in Computer Science book series (LNCS, VOL 9351). DOI: 10.1007/978-3-319-24574-4_28. |

| [8] | Dou Q, Yu L, Chen H, et al. 3D deeply supervised network for automated segmentation of volumetric medical images[J]. Med Image Anal, 2017, 41: 40-54. DOI:10.1016/j.media.2017.05.001 |

| [9] | Song X, Wang Y, Feng Q, et al. Improved graph cut model with features of superpixels and neighborhood patches for myocardium segmentation from ultrasound image[J]. Math Biosci Eng, 2019, 16(3): 1115-1137. DOI:10.3934/mbe.2019053 |

| [10] | He K, Zhang X, Ren S, et al. Delving deep into rectifiers: Surpassing human-level performance on imagenet classification[C]//Proceedings of the IEEE international conference on computer vision. 2015: 1026-1034. |

| [11] | Kingma D P, Ba J. Adam: A method for stochastic optimization[J]. arXiv preprint arXiv: 1412.6980, 2014. http://arxiv.org/abs/1412.6980 |

2019, Vol. 28

2019, Vol. 28